智慧工廠大數據平臺數據處理服務建設方案

一、建設背景與目標

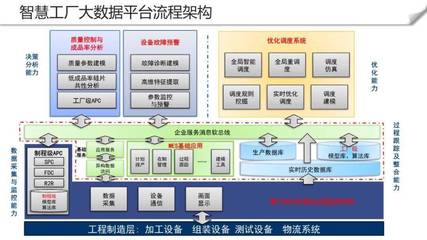

隨著工業4.0時代的到來,智慧工廠已成為制造業轉型升級的重要方向。大數據平臺作為智慧工廠的核心基礎設施,其數據處理服務能力直接影響工廠的智能化水平和運營效率。本方案旨在構建一個高效、穩定、可擴展的數據處理服務體系,為智慧工廠提供全方位的數據支撐。

二、數據處理服務架構設計

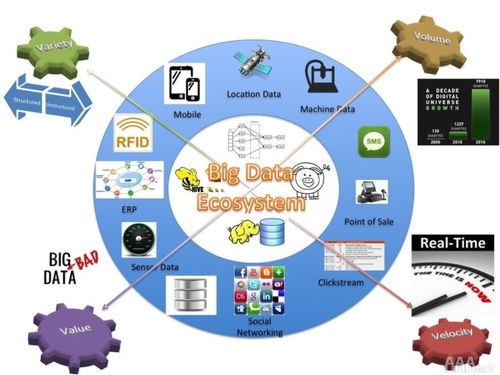

1. 數據采集層

- 設備數據采集:通過工業網關、傳感器等設備實時采集生產設備運行數據

- 業務系統集成:對接ERP、MES、SCADA等系統,獲取業務管理數據

- 外部數據接入:整合供應鏈、市場環境等外部數據源

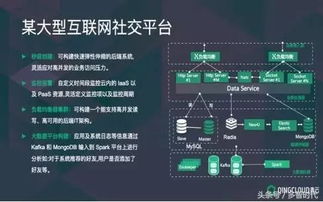

2. 數據存儲層

- 實時數據庫:存儲設備實時監控數據,支持毫秒級響應

- 數據湖:構建企業級數據湖,存儲結構化與非結構化數據

- 數據倉庫:建立主題式數據倉庫,支撐業務分析需求

3. 數據處理層

- 流式處理:采用Flink、Spark Streaming等技術實現實時數據處理

- 批處理:構建ETL/ELT數據處理流水線,實現批量數據加工

- 數據融合:整合多源異構數據,形成統一數據視圖

4. 數據服務層

- 數據API服務:提供標準化數據接口,支持業務系統調用

- 數據可視化:開發數據看板、報表等可視化工具

- 數據分析:內置機器學習算法,支持預測性維護等場景

三、核心數據處理服務功能

1. 實時數據處理服務

- 設備狀態實時監控:毫秒級響應設備異常狀態

- 生產過程實時分析:實時計算生產指標,優化生產調度

- 質量實時控制:實時檢測產品質量,及時預警

2. 批處理數據服務

- 數據清洗與標準化:自動識別并處理數據質量問題

- 數據關聯與整合:建立設備、工藝、質量等數據的關聯關系

- 數據歸檔與備份:建立完善的數據生命周期管理體系

3. 智能分析服務

- 預測性維護:基于設備運行數據預測故障風險

- 工藝優化:通過數據分析發現工藝改進空間

- 能源管理:實時監控能耗,優化能源使用效率

四、技術實現方案

1. 技術選型

- 數據處理框架:Apache Flink、Apache Spark

- 消息隊列:Kafka、Pulsar

- 存儲系統:HDFS、HBase、ClickHouse

- 容器化部署:Kubernetes、Docker

2. 數據處理流程

- 數據接入:通過數據采集網關接入各類數據源

- 數據解析:解析數據格式,進行初步清洗

- 數據校驗:驗證數據完整性和準確性

- 數據轉換:標準化數據格式,統一數據模型

- 數據加載:加載到目標存儲系統

- 數據服務:通過API或可視化方式提供服務

3. 性能保障措施

- 分布式架構設計,支持水平擴展

- 負載均衡機制,確保系統穩定運行

- 數據壓縮與索引優化,提升查詢效率

- 緩存機制設計,減少重復計算

五、實施規劃與效益評估

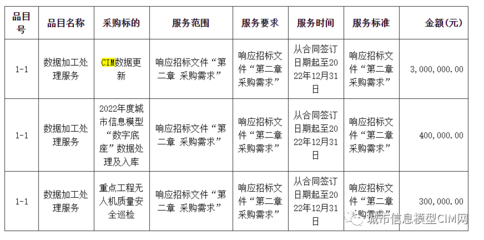

1. 分階段實施計劃

- 第一階段(3個月):基礎平臺搭建,核心數據采集

- 第二階段(6個月):數據處理服務完善,關鍵應用開發

- 第三階段(12個月):全面推廣應用,持續優化提升

2. 預期效益

- 生產效率提升:預計提升15%-20%

- 故障率降低:預期降低設備故障率30%

- 質量控制:產品質量一致性提升25%

- 成本節約:預計降低維護成本20%

六、保障措施

- 安全機制:建立完善的數據安全防護體系

- 運維監控:實現7×24小時系統監控與告警

- 技術支持:組建專業的技術支持團隊

- 培訓體系:建立全員數據素養提升計劃

本方案通過構建全面的數據處理服務體系,將為智慧工廠提供強大的數據支撐能力,助力企業實現數字化、智能化轉型,在激烈的市場競爭中贏得先機。

如若轉載,請注明出處:http://www.xiaokouwei.cn/product/4.html

更新時間:2026-01-12 11:58:56